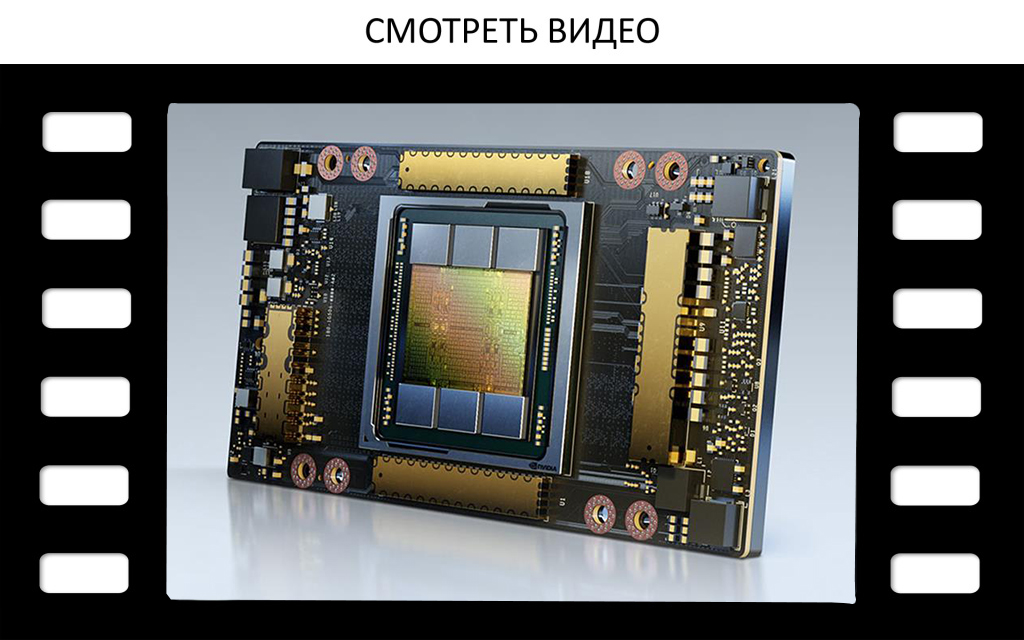

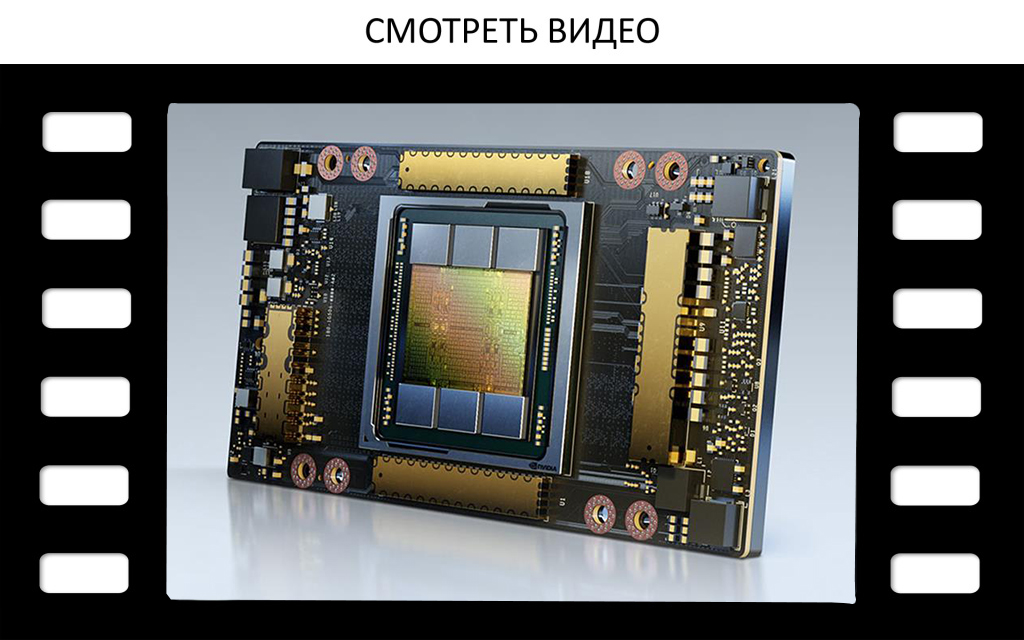

Nvidia выпустила ускоритель A100 c 80 ГБ памяти

Это новая версия А100 (40 ГБ памяти HBM2e), представленного в мае этого года. В ноябре были запущены первые инстансы AWS на A100 (инстансы EC2 P4d). Пропускная способность памяти в новой версии доведена до 3,2 Гбит/с на каждый пин, что даёт в сумме пропускную способность всей памяти 2 ТБ/с.

Nvidia не снимает старую модель с производства и будет одновременно продавать 40- и 80-гигабайтные версии. Основные заказчики — клиенты с большими наборами данных для обучения систем ИИ.

Сравнение первого и второго поколения А100 с 40 и 80 ГБ памяти

Nvidia не снимает старую модель с производства и будет одновременно продавать 40- и 80-гигабайтные версии. Основные заказчики — клиенты с большими наборами данных для обучения систем ИИ.

Сравнение первого и второго поколения А100 с 40 и 80 ГБ памяти

Единственное различие между 40-и 80-гигабайтной версиями A100 заключается в объёме и пропускной способности памяти. Обе модели сделаны на базе графических процессоров GA100 с максимальной тактовой частотой 1,41 ГГц. TDP у двух моделей тоже не отличается.

В новом A100 сохранилась та же конфигурация 5/6 стеков, но здесь поставили новую память HBM2E. Это неофициальное название для последнего поколения стандарта памяти HBM2 с рекордной пропускной способностью 3,2 Гбит/с на пин. Улучшения в техническом процессе позволили производителю удвоить ёмкость памяти. Конечным результатом является то, что HBM2E предлагает и больше ёмкость, и больше полосу пропускания.

Nvidia выпускает A100 на серверных платах HGX и DGX. Для клиентов, которым нужны отдельные экземпляры ускорителя, по-прежнему предлагаются A100 в исполнении PCIe, хотя в варианте 80 ГБ они пока не доступны.

Конфигурация DGX — это новинка. В такую систему устанавливается восемь ускорителей, так что совокупный объём памяти достигает 640 ГБ.

Также доступна рабочая станция DGX Station A100 - усечённая наполовину DGX A100 с четырьмя ускорителями A100 и одним процессором AMD EPYC.

Энергопотребление пока неизвестно, но на пресс-конференции, заявили, что рабочая станция «работает от обычной розетки». Для сравнения, потребляемая мощность стандартной DGX A100 составляет 6,5 кВт.

Рабочая станция DGX Station A100

Массовое производство обеих систем уже началось. Nvidia говорит, что они работают в нескольких небольших суперкомпьютерах, таких как Cambridge-1. Но продажи для всех желающих планируются только в феврале 2021 года.

Nvidia выпустила ускоритель A100 c 80 ГБ памяти

Nvidia выпустила ускоритель A100 c 80 ГБ памяти

Nvidia выпустила ускоритель A100 c 80 ГБ памяти

ОЭС Спецпоставка

Это новая версия А100 (40 ГБ памяти HBM2e), представленного в мае этого года. В ноябре были запущены первые инстансы AWS на A100 (инстансы EC2 P4d).? Пропускная способность памя...

Это новая версия А100 (40 ГБ памяти HBM2e), представленного в мае этого года. В ноябре были запущены первые инстансы AWS на A100 (инстансы EC2 P4d). Пропускная способность памяти в новой версии доведена до 3,2 Гбит/с на каждый пин, что даёт в сумме пропускную способность всей памяти 2 ТБ/с.

Nvidia не снимает старую модель с производства и будет одновременно продавать 40- и 80-гигабайтные версии. Основные заказчики — клиенты с большими наборами данных для обучения систем ИИ.

Сравнение первого и второго поколения А100 с 40 и 80 ГБ памяти

Единственное различие между 40-и 80-гигабайтной версиями A100 заключается в объёме и пропускной способности памяти. Обе модели сделаны на базе графических процессоров GA100 с максимальной тактовой частотой 1,41 ГГц. TDP у двух моделей тоже не отличается.

В новом A100 сохранилась та же конфигурация 5/6 стеков, но здесь поставили новую память HBM2E. Это неофициальное название для последнего поколения стандарта памяти HBM2 с рекордной пропускной способностью 3,2 Гбит/с на пин. Улучшения в техническом процессе позволили производителю удвоить ёмкость памяти. Конечным результатом является то, что HBM2E предлагает и больше ёмкость, и больше полосу пропускания.

Nvidia выпускает A100 на серверных платах HGX и DGX. Для клиентов, которым нужны отдельные экземпляры ускорителя, по-прежнему предлагаются A100 в исполнении PCIe, хотя в варианте 80 ГБ они пока не доступны.

Конфигурация DGX — это новинка. В такую систему устанавливается восемь ускорителей, так что совокупный объём памяти достигает 640 ГБ.

Также доступна рабочая станция DGX Station A100 - усечённая наполовину DGX A100 с четырьмя ускорителями A100 и одним процессором AMD EPYC.

Энергопотребление пока неизвестно, но на пресс-конференции, заявили, что рабочая станция «работает от обычной розетки». Для сравнения, потребляемая мощность стандартной DGX A100 составляет 6,5 кВт.

Рабочая станция DGX Station A100

Массовое производство обеих систем уже началось. Nvidia говорит, что они работают в нескольких небольших суперкомпьютерах, таких как Cambridge-1. Но продажи для всех желающих планируются только в феврале 2021 года.